"Hầu hết mô hình AI lớn đều thiếu sự hiểu biết sâu sắc về bản chất thực tế của kiến thức - rằng kiến thức vốn dĩ đòi hỏi sự thật", đại diện nhóm nghiên cứu Đại học Stanford nói với tạp chí Nature Machine Intelligence. "Điều đó có thể gây ra những hậu quả đáng lo ngại, do chúng ngày càng được áp dụng phổ biến trong các lĩnh vực từ luật đến y học, nơi mà khả năng phân biệt sự thật với hư cấu trở nên cấp thiết. Việc không phân biệt có thể dẫn đến chẩn đoán sai, làm sai lệch phán quyết của tòa án và khuếch đại thông tin sai lệch".

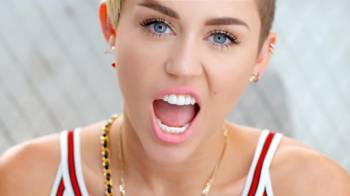

Một số ứng dụng AI tạo sinh trên điện thoại Copilot, DeepSeek, Gemini, AI Hay, ChatGPT, Grok. Ảnh: Lưu Quý

Để dẫn đến kết luận này, nhóm nghiên cứu Đại học Stanford đã sử dụng 24 mô hình AI lớn phổ biến nhất hiện nay, gồm ChatGPT, Claude AI, DeepSeek hay Gemini. Chúng sau đó được hỏi 13.000 câu hỏi để đánh giá khả năng phân biệt giữa niềm tin, kiến thức và sự thật.

Nhóm nghiên cứu nhận thấy, nhìn chung, các mô hình ít có khả năng phân biệt "niềm tin sai" với "niềm tin đúng". Những chatbot phát hành trong hoặc sau tháng 5/2024 đạt độ chính xác từ 91,1% đến 91,5% khi xác định thông tin đúng hoặc sai, trong khi các mô hình cũ hơn chỉ đạt từ 71,5% đến 84,8%.

"Chat bot gặp khó khăn trong việc nắm bắt bản chất của kiến thức", đại diện nhóm nghiên cứu nói. "Chiến lược lập luận của chúng không nhất quán, gợi ý và khớp mẫu hời hợt thay vì sự nhận thức sâu sắc liên quan đến kiến thức hoặc mức độ hiểu biết".

Từ kết quả này, nhóm chuyên gia Đại học Stanford kêu gọi các công ty đang phát triển mô hình AI cần "những cải tiến khẩn cấp" trước khi được triển khai trong các lĩnh vực có rủi ro cao như luật pháp, y học... nơi khả năng phân biệt sự thật với hư cấu là điều cần thiết.

Một số kiểm nghiệm thực tế gần đây cũng cho thấy các mô hình ngôn ngữ lớn (LLM) nắm bắt thực tế chưa chuẩn xác. Chẳng hạn, trong bài đăng trên LinkedIn, nhà sáng tạo và nhà đầu tư người Anh David Grunwald đã đề nghị AI Grok làm cho ông một "tấm áp phích của mười vị thủ tướng Anh gần đây nhất". Kết quả dường như đầy rẫy lỗi nghiêm trọng, chẳng hạn gọi Rishi Sunak là "Boris Johnson", hay liệt kê bà Theresa May "đã phục vụ từ năm 5747 đến năm 70".

Pablo Haya Coll, chuyên gia ngôn ngữ học máy tính tại Đại học Autonomous Madrid (UAM), đánh giá kết quả nghiên cứu "đáng lo ngại", đồng thời cho rằng cần có giải pháp đào tạo các mô hình nhằm giúp chúng phản hồi theo cách thận trọng hơn. Theo Coll, những phát hiện này phơi bày điểm yếu về mặt cấu trúc trong các mô hình ngôn ngữ: khó khăn trong việc phân biệt chắc chắn giữa niềm tin chủ quan và sự thật khách quan tùy thuộc vào cách một khẳng định nhất định được xây dựng.

"Những thiếu sót có thể gây hậu quả nghiêm trọng trong các lĩnh vực đòi hỏi sự phân biệt thật giả, như luật pháp, y học hoặc báo chí, nơi mà việc nhầm lẫn niềm tin với kiến thức có thể dẫn đến những sai lầm nghiêm trọng trong phán đoán", Coll nói với Independent.

Kết quả nghiên cứu xuất hiện trong bối cảnh AI ngày càng được tin cậy trong tìm kiếm thông tin. Một khảo sát của Adobe Express giữa năm nay cho thấy, 77% người Mỹ sử dụng ChatGPT coi nó như một công cụ tìm kiếm, trong khi ba trong số 10 người dùng chatbot này tin tưởng "hơn cả một công cụ tìm kiếm".

Hồi tháng 5, một thẩm phán ở California đã phạt hai công ty luật 31.000 USD sau khi phát hiện lấy thông tin sai từ ChatGPT vào bản tóm tắt pháp lý mà không có bất kỳ sự thẩm định nào. Vào tháng 6, một luật sư ở bang Utah bị tòa xử phạt sau khi hồ sơ kháng cáo của thân chủ được phát hiện sử dụng ChatGPT và AI đã "bịa" một vụ án không tồn tại. Tháng 7, hai luật sư ở Colorado phải nộp phạt 3.000 USD mỗi người sau khi nộp tài liệu được viết bằng AI trích dẫn các vụ án không tồn tại và dẫn chứng sai luật. Năm 2023, hai luật sư tại New York cũng từng bị phạt 5.000 USD vì nộp bản tóm tắt quan điểm bào chữa có trích dẫn các vụ án giả mạo. Họ thừa nhận đã sử dụng ChatGPT.

Bảo Lâm (theo NYPost, Independent)

- OpenAI bị chỉ trích vì đưa nội dung khiêu dâm vào ChatGPT

- Người Việt dành gần 300 triệu giờ cho ứng dụng AI trong nửa năm

- Chatbot AI có thể khiến não người lười vận động

- Giới trẻ dần cập nhật tin tức qua ChatGPT