Tiến sĩ Heather Domin là Phó chủ tịch kiêm Trưởng Văn phòng Trí tuệ nhân tạo có trách nhiệm (Chief Responsible AI Officer) và Quản trị Trí tuệ nhân tạo (AI Governance) tại HCLTech - một trong những tập đoàn công nghệ hàng đầu Ấn Độ. Bà từng dẫn dắt sáng kiến AI có trách nhiệm toàn cầu tại IBM, có tên trong danh sách 100 phụ nữ xuất sắc trong lĩnh vực Đạo đức AI 2025, do tổ chức Women in AI Ethics (WAIE) bình chọn thường niên từ 2018.

Trong bối cảnh AI phát triển mạnh nhưng kéo theo nhiều nguy cơ mất an toàn, bà chia sẻ với VnExpress về việc triển khai AI có trách nhiệm, cũng như hướng xây dựng chính sách phát triển lĩnh vực này.

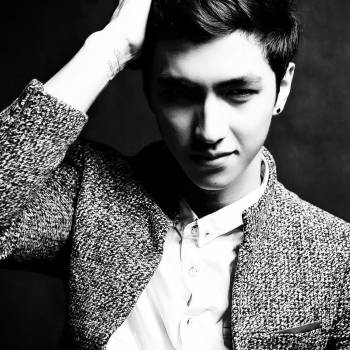

Tiến sĩ Heather Domin. Ảnh: NVCC

- AI có trách nhiệm (Responsible AI) là khái niệm mới mẻ với số đông. Là một trong những người đi đầu, bà có thể chia sẻ cụ thể công việc của mình?

- Nói đến Responsible AI, tôi thường nhấn mạnh một điều: đó không phải là dự án riêng lẻ hay "bộ quy tắc đạo đức" đặt bên ngoài công nghệ. Đó là cách chúng ta tư duy, thiết kế và ra quyết định trong toàn bộ hành trình của AI.

Công việc hàng ngày của tôi là kết nối rất nhiều nhóm, từ nhà khoa học dữ liệu, kỹ sư, nhóm sản phẩm đến bộ phận pháp lý và chiến lược, để bảo đảm những nguyên tắc đạo đức không chỉ nằm trong tài liệu, mà thực sự đi vào từng dòng mã, từng quyết định thiết kế và cách AI được sử dụng.

Một Chief Responsible AI Officer (CRAO) không chỉ cần hiểu kỹ thuật, mà còn phải có tư duy hệ thống, năng lực quản trị và đặc biệt là sự đồng cảm với người dùng. Bởi AI không chỉ là công nghệ, nó chạm đến niềm tin của con người. Tôi tin khi AI trở thành trung tâm của chiến lược doanh nghiệp, vai trò lãnh đạo Responsible AI sẽ dần chuyển từ chức năng cố vấn sang cấp điều hành. Hiện đã có hơn 33% doanh nghiệp thuộc Fortune 1000 có vị trí Chief AI Officer. Trong tương lai, chúng ta có thể thấy các CEO xuất thân từ nền tảng Responsible AI - những người có khả năng cân bằng giữa đổi mới, đạo đức và quản trị rủi ro.

- Với lĩnh vực mới như AI, lựa chọn trách nhiệm đôi khi phải đánh đổi bằng hiệu quả. Trong hành trình triển khai, bà xử lý bài toán này thế nào?

- Đây là một thách thức tương đối phổ biến, đặc biệt trong làn sóng chạy đua ra mắt mô hình mới, nhiều công ty bị cuốn vào quỹ đạo "phải nhanh hơn đối thủ", đôi khi quên rằng niềm tin người dùng mới là yếu tố quyết định sự sống còn dài hạn. Tôi từng chứng kiến nhiều doanh nghiệp phải trả giá vì bỏ qua khâu kiểm định đạo đức, dẫn đến sự cố hoặc khủng hoảng truyền thông. Ngược lại, những đơn vị đầu tư nghiêm túc vào Responsible AI từ sớm lại tiết kiệm được thời gian và chi phí về sau, bởi ngăn được rủi ro ngay từ gốc.

Để tránh những căng thẳng có thể xảy ra, chúng tôi không xem việc thực thi AI có trách nhiệm như một danh sách cần kiểm tra, mà là tư duy nền tảng của đổi mới. Khi nhóm kỹ sư hiểu rõ vì sao mô hình cần công bằng, khi lãnh đạo coi minh bạch là giá trị cốt lõi, thì "AI có trách nhiệm" không còn là rào cản mà trở thành lợi thế cạnh tranh. Cách tiếp cận tốt nhất là xác định rõ các nguyên tắc đạo đức ngay từ đầu quá trình phát triển sản phẩm. Lợi ích ngắn hạn về thương mại cần được cân bằng với mục tiêu xây dựng niềm tin và uy tín thương hiệu dài hạn.

- Theo bà, "AI có trách nhiệm" nên là tự nguyện hay bắt buộc tuân thủ, thực tế chúng đang được triển khai thế nào?

- Cần triển khai song song cả hai hướng này. Có hai khái niệm khác nhau nhưng đôi khi bị nhầm lẫn, là "quản trị AI" và "AI có trách nhiệm".

Quản trị (Governance) giúp đảm bảo tuân thủ các tiêu chuẩn pháp lý, còn "trách nhiệm" (Responsibility) tiến xa hơn một bước - thúc đẩy trách nhiệm giải trình, công bằng, an toàn, quyền riêng tư và tính minh bạch trong cách thức AI được phát triển và sử dụng.

Trên toàn cầu, chúng ta có thể chứng kiến sự chuyển dịch từ các nguyên tắc tự nguyện sang quy định bắt buộc, với ví dụ tiêu biểu là Đạo luật AI của Liên minh châu Âu (EU AI Act). Các quy định sẽ đặt ra lằn ranh đỏ, giúp đảm bảo mức độ trách nhiệm cơ bản, trong khi các sáng kiến tự nguyện thúc đẩy sự sáng tạo thực chất trong khuôn khổ an toàn.

Với các quốc gia mới nổi như Việt Nam, tôi nghĩ đây chính là thời điểm vàng để thiết lập khung quản trị AI mang bản sắc riêng: vừa linh hoạt, vừa hài hòa với tiêu chuẩn quốc tế. Việt Nam có cơ hội tránh được sai lầm mà các quốc gia đi trước vấp phải. Mục tiêu cuối cùng vẫn là bảo vệ lợi ích công chúng mà không kìm hãm đổi mới.

- Nhiều doanh nghiệp cũng nói về "AI có trách nhiệm", làm sao để tin được rằng họ thực sự tuân thủ chứ không chỉ là quảng cáo? Có dấu hiệu hoặc chỉ số nào để nhận biết một doanh nghiệp đang làm đúng hướng?

- Theo tôi, tính minh bạch phải là yếu tố then chốt, dù với AI hay bất cứ lĩnh vực nào. Những công ty nghiêm túc với Responsible AI sẽ công khai khung nguyên tắc đạo đức, quy trình đánh giá mô hình, hoặc có báo cáo kiểm toán AI độc lập từ bên thứ ba.

Họ cũng sẽ đầu tư cho con người, đào tạo đội ngũ kỹ sư hiểu về đạo đức dữ liệu, tạo cơ chế để người dùng phản hồi, hỗ trợ khách hàng kiểm thử mô hình. Quan trọng nhất, Responsible AI phải tích hợp vào văn hóa doanh nghiệp và tầm nhìn lãnh đạo, chứ không chỉ xuất hiện trong chiến dịch tiếp thị.

Một yếu tố quan trọng khác là dữ liệu. Dữ liệu được coi như "nhiên liệu" của AI, nên vấn đề đạo đức dữ liệu cũng đặc biệt quan trọng. Với các quốc gia như Việt Nam, tôi khuyến nghị bắt đầu bằng việc xây dựng nguồn dữ liệu sạch, minh bạch và có tính đại diện, đồng thời tôn trọng quyền lợi của người đóng góp. Cần tránh sử dụng dữ liệu không được xác minh hoặc thiên lệch, tôn trọng quyền lợi của những người liên quan đến dữ liệu.

Thực hành "đạo đức dữ liệu" sẽ giúp xây dựng niềm tin của người tiêu dùng và đảm bảo tuân thủ pháp lý lâu dài. Khi người dân tin dữ liệu của họ được sử dụng đúng mục đích, đó chính là nền tảng cho đổi mới bền vững.

- Nhiều doanh nghiệp Việt Nam đang thử nghiệm AI Agent (tác nhân AI) - những hệ thống có khả năng ra quyết định tự chủ. Bà có lời khuyên gì về AI có trách nhiệm với họ, và khi AI mắc lỗi, trách nhiệm thuộc về ai?

- AI Agent có thể mang lại tiềm năng lớn nhưng cũng tiềm ẩn rủi ro. Khi AI bắt đầu hành động thay con người, câu hỏi "ai chịu trách nhiệm khi nó sai?" sẽ trở thành vấn đề dễ gây tranh cãi.

Theo tôi, lời giải nằm ở quản trị con người trong vòng kiểm soát (human-in-the-loop). Dù hệ thống có thông minh đến đâu, vẫn cần cơ chế giám sát, can thiệp và truy vết quyết định. Nếu xây dựng được khung quản trị đủ rõ ràng, AI Agent sẽ không còn là hệ thống tự chủ, mà là đối tác đồng hành của con người.

Trách nhiệm cũng cần được xác định rõ ở mọi giai đoạn, từ nhà phát triển, đơn vị triển khai đến người dùng cuối. Các khung quản trị nên cho phép xác định trách nhiệm và ra quyết định rõ ràng trong trường hợp xảy ra sự cố. Mục tiêu là xây dựng hệ thống không chỉ mang tính đạo đức mà còn đảm bảo tính minh bạch và khả năng kiểm toán. Tại những quốc gia như Việt Nam, nơi phát triển AI đang ở giai đoạn đầu, đây là cơ hội quý giá để tích hợp sớm các nguyên tắc này.

- Bà có lời khuyên gì khi Việt Nam đang trong quá trình xây dựng Luật Trí tuệ nhân tạo?

- Tôi đánh giá cao Việt Nam là một trong những quốc gia đầu tiên có Luật về AI. Một bộ luật sớm giúp định hình niềm tin và hướng đi dài hạn cho phát triển.

Theo tôi, quy định về AI của Việt Nam nên dựa trên các nguyên tắc cốt lõi: trách nhiệm, công bằng, an toàn, quyền riêng tư và tính minh bạch. Tuy nhiên, luật cần linh hoạt, vì không thể áp một khung quy định chung cho mọi trường hợp sử dụng. Thay vào đó, cần mô hình quản trị dựa trên mức độ rủi ro, điều chỉnh phù hợp với từng ứng dụng AI cụ thể. Ví dụ cần các quy định chặt chẽ, đặt ra yêu cầu rõ ràng với hệ thống có rủi ro cao, nhưng đồng thời cũng cho phép doanh nghiệp tự điều chỉnh với ứng dụng ít rủi ro hơn. Cần có sự phối hợp ba bên: cơ quan quản lý - giới học thuật - doanh nghiệp. Mỗi bên có góc nhìn khác nhau, và chỉ khi cùng ngồi lại, chúng ta mới có thể xây dựng hệ sinh thái AI bền vững, phục vụ con người.

Nếu được đưa ra lời khuyên cho nhà lãnh đạo, nhà sáng lập và nhà hoạch định chính sách Việt Nam, tôi sẽ nói: hãy bắt đầu bằng trách nhiệm. Responsible AI cần được coi như một phần không thể tách rời từ đầu, chứ đừng chờ đến khi sản phẩm hoàn thiện mới nghĩ đến đạo đức.

Để làm được điều đó, phải đầu tư vào giáo dục, nghiên cứu, thử nghiệm và các công cụ hỗ trợ phát triển AI có trách nhiệm. Và đặc biệt, hãy tạo ra sự hợp tác đa bên: doanh nghiệp, chính phủ, trường đại học và xã hội, bởi AI không chỉ là câu chuyện công nghệ, mà là tương lai của cách chúng ta sống, làm việc và tin tưởng lẫn nhau.

Những quốc gia đi đầu trong việc phát triển AI có đạo đức hôm nay sẽ là những quốc gia dẫn đầu đổi mới AI toàn cầu ngày mai.

Lưu Quý