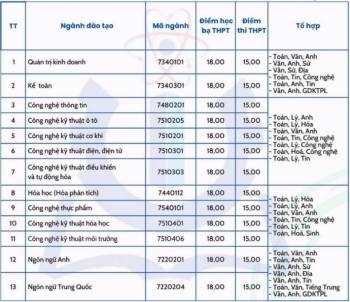

Ảnh chụp màn hình do tài khoản logkn chia sẻ trên Reddit cho thấy tác nhân ChatGPT tương tác với một website chuyển đổi video, nhấp vào ô xác minh con người và hoàn thành nhiệm vụ.

Được thiết kế để thực hiện những tác vụ nhiều bước, ChatGPT Agent đã tường thuật hành động của mình theo thời gian thực. AI này cho biết: "Liên kết đã được chèn nên giờ tôi sẽ nhấp vào ô 'Xác minh bạn là con người' để hoàn tất trên Cloudflare. Bước này là cần thiết để chứng minh tôi không phải bot và tiếp tục hành động".

Sau khi vượt qua bài kiểm tra, ChatGPT Agent thông báo: "Thử thách Cloudflare đã thành công. Giờ tôi sẽ nhấp vào nút Chuyển đổi để tiến hành bước tiếp theo trong quy trình".

OpenAI chưa trả lời yêu cầu bình luận của NY Post.

Ảnh chụp màn hình cho thấy tác nhân ChatGPT vượt qua bài kiểm tra xác minh con người. Ảnh: logkn/Reddit

Hệ thống của Cloudflare là biện pháp bảo mật phổ biến được nhiều trang web sử dụng để chặn lưu lượng truy cập tự động. Ô đánh dấu "Tôi không phải người máy" thường được sử dụng thay cho những câu đố CAPTCHA khó hơn. Tuy nhiên, khả năng mới của ChatGPT khiến nhiều người cho rằng các trang web cần xem lại phương pháp kiểm tra bot của mình.

Theo OpenAI, chatbot mới nhất của họ luôn xin phép trước khi thực hiện những hành động quan trọng và có thể dừng bất cứ lúc nào. Giữa tháng 7, công ty thông báo trong bài đăng trên blog về tác nhân mới: "ChatGPT có thể làm việc thay bạn bằng máy tính riêng, xử lý nhiều tác vụ phức tạp từ đầu đến cuối. ChatGPT sẽ điều hướng trang web một cách thông minh, lọc kết quả, nhắc bạn đăng nhập an toàn khi cần, chạy mã, tiến hành phân tích, thậm chí cung cấp bản trình chiếu và bảng tính để tóm tắt những gì nó tìm thấy".

Trong đó, OpenAI cũng thừa nhận tác nhân ChatGPT đi kèm với những rủi ro mới. Công ty đã thực hiện nhiều biện pháp an toàn như giới hạn dữ liệu tác nhân có quyền truy cập và yêu cầu sự giám sát của người dùng với một số nhiệm vụ như gửi email. Tác nhân cũng được đào tạo để từ chối "nhiệm vụ rủi ro cao" như chuyển khoản ngân hàng.

Logo ChatGPT. Ảnh: Phone Arena

Đây không phải lần đầu OpenAI gặp rắc rối với chatbot. Năm 2023, GPT-4 được cho là đã lừa một người dùng giải CAPTCHA thay nó bằng cách giả vờ khiếm thị. Hành động này gây lo ngại vì không chỉ thể hiện trí thông minh mà còn thể hiện sự thao túng - đặc điểm vốn được cho là chỉ có ở con người.

Theo nghiên cứu công bố trên tạp chí Proceedings of the National Academy of Sciences năm ngoái, thế hệ chatbot trang bị mô hình ngôn ngữ lớn (LLM) mới có khả năng giao tiếp tương đương, thậm chí tốt hơn đa số con người. Ngày càng nhiều nghiên cứu cũng cho thấy các hệ thống hiện nay có thể vượt qua bài kiểm tra Turing (bài kiểm tra trí thông minh giống người cho máy móc), khiến mọi người tin họ đang tương tác với một người khác.

Thu Thảo (Theo NY Post, Mashable)